Administração do Serviço

Administração do Robots.txt

O serviço Robots.txt possui um ambiente administrativo para adição de configurações de user-Agents que irão compor o robots.txt.

É importante ressaltar que este ambiente não permite criar robots.txt e sim adicionar informações de quais user-Agents poderão acessar o robots.txt de uma determinada instância de serviço para uma determinada solução.

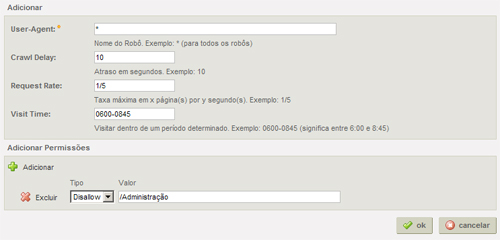

Para adicionar configuraçõesbasta clicar em Adicionar e preencher as seguintes informações:

- UserAgent :nome do user-Agent que irá compor o robots.txt.Ao informar "*" para esse campo, está informando que quaisquer user-Agent poderá acessar esse robots.txt;

- Crawl Delay: o intervalo em segundos que o user-Agent do mecanismo de buscar irá requisitar uma página, uma vez lido o robots.txt;

- Request Rate: quantidade de páginas por tantos segundos que o user-Agent do mecanismo de busca irá navegar e indexar uma página;

- Visit Time: o intervalo de horário em que a requisição poderá ser realizada;

- Adicionar Permissões: é possível adicionar tantas permissões de acesso para diferentes caminhos de páginas, quanto forem necessárias. Portanto, para cada path de página pode-se atribuir a permissao allow ou disallow. Geralmente, defini-se apenas uma lista de paths que estão "disallow". Se desejar que algumas páginas abaixo de determinados paths não permitidos sejam permitidas, basta configurar como "allow".

É possível e necessário informar as URLS das seções e páginas que não estão disponíveis pela navegação através de links e menus. Tais URLs estão através disponíveis através de sitemapsque devem cadastrados para que os robots.txtos consultem.

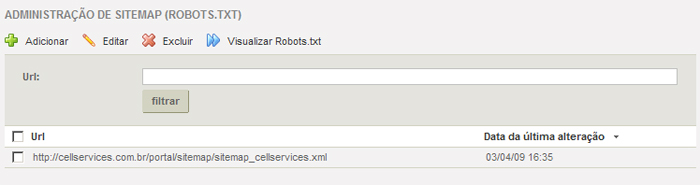

Administração de Sitemap

Nesta administração é possível informar os sitemaps contidos no robots.txt para que o user-Agent possa navegar nas páginas que não são acessadas pela navegação normal em uma na solução.

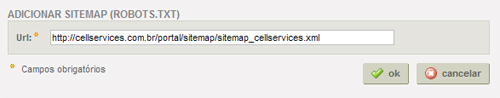

Para informar os sitemaps (um por vez) que o robots.txt irá utilizar, deve-se clicar em Adicionar e preencher a seguinte informação:

- URL:Deve-se informar a URL formada no cadastro de sitemaps na instância de serviço desejada de sitemap.Lembrando que a URL é formada por: URL da solução/sitemap/arquivo_xml_gerado_do_sitemap.

Através da administração de sitemap do robots.txttambém pode-se visualizar a composição do robots.txtjá com a informação dos sitemaps (se houver).